KI-Modelle verstehen

Die Welt der Künstlichen Intelligenz (KI) – oder auf Englisch: Artificial Intelligence (AI) – ist faszinierend und komplex. Um sie zu verstehen, beginnen wir mit der grundlegendsten Frage: Was sind KI-Modelle? Künstliche Intelligenz bezieht sich auf Systeme oder Maschinen, die menschenähnliche Intelligenz nachahmen, um Aufgaben auszuführen und dabei aus Erfahrungen lernen. KI-Modelle sind die algorithmischen Bausteine dieser Systeme. Sie sind mathematische Modelle, die auf Daten trainiert werden, um Muster zu erkennen, Vorhersagen und Entscheidungen zu treffen.

Das Whitepaper KI im Marketing ist für alle, die die Potenziale von Künstlicher Intelligenz im Marketing entdecken möchten. In unserem Whitepaper erwartet Sie:

Lesen Sie in unserem Whitepaper, wie vier innovative KI-Tools das Marketing optimieren und profitieren Sie von unserem exklusiven Implementierungstool, das Sie Schritt für Schritt bei der Einführung von KI in Ihrem Unternehmen begleitet – ein unverzichtbarer Leitfaden für den modernen Marketer.

Die historische Entwicklung der KI lässt sich bis in die Mitte des 20. Jahrhunderts zurückverfolgen. Die Anfänge der KI als akademische Disziplin werden oft mit der Dartmouth Conference von 1956 in Verbindung gebracht, wo der Begriff “Künstliche Intelligenz” geprägt wurde. Wissenschaftler wie Alan Turing, der bereits in den 1940er Jahren mit seinen Überlegungen zur “Turing-Maschine” und dem berühmten “Turing-Test” grundlegende Konzepte der KI formulierte, legten den Grundstein für die heutige KI-Forschung.

In den darauf folgenden Jahrzehnten erlebte die KI-Entwicklung Phasen von Optimismus und Enttäuschung, oft bezeichnet als “KI-Frühling” und “KI-Winter”. Die frühen Modelle der KI basierten hauptsächlich auf regelbasierten Systemen und einfachen neuronalen Netzwerken. Diese Systeme waren in ihrer Fähigkeit, komplexe Probleme zu lösen, begrenzt, zeigten aber das Potenzial der KI.

Ein Wendepunkt in der KI kam mit dem Aufkommen von “Deep Learning” in den frühen 2000er Jahren. Deep Learning, eine Unterform des maschinellen Lernens, verwendet tiefe neuronale Netzwerke, die aus vielen Schichten bestehen, um komplexe Muster in großen Datenmengen zu erkennen. Der Durchbruch kam 2012, als ein tieferes neuronales Netzwerk namens “AlexNet” beeindruckende Ergebnisse in einem Bilderkennungswettbewerb erzielte.

Seitdem hat die KI-Entwicklung rapide Fortschritte gemacht, getrieben durch die zunehmende Verfügbarkeit großer Datenmengen, leistungsstärkere Rechenkapazitäten und Fortschritte in den Algorithmen. Heutige KI-Modelle reichen von fortgeschrittenen neuronalen Netzwerken, die in der Lage sind, komplexe Aufgaben wie Sprach- und Bilderkennung zu bewältigen, bis hin zu spezialisierten Modellen für spezifische Anwendungen wie automatisiertes Fahren oder medizinische Diagnostik.

Die Geschichte der KI ist eine Geschichte von Innovation, Herausforderung und ständiger Weiterentwicklung. Was als kleine Gruppe von Wissenschaftlern begann, die über die Möglichkeit maschineller Intelligenz nachdachten, hat sich zu einem der dynamischsten und einflussreichsten Forschungsfelder der modernen Zeit entwickelt. Die folgende Auflistung gibt einen Überblick über die Geschichte und Timeline von KI:

1950 – Alan Turing und der Turing-Test: Alan Turing stellt den Turing-Test vor, eine Methode zur Beurteilung, ob eine Maschine intelligentes Verhalten gleichwertig oder nicht unterscheidbar von dem eines Menschen zeigen kann.

1956 – Dartmouth-Konferenz: Dieses Treffen gilt als die Geburtsstunde der KI als eigenständiges Forschungsfeld. Hier wurde der Begriff “Artificial Intelligence” geprägt.

1960er – Frühe KI-Programme: Entwicklung früher KI-Programme wie ELIZA (1966), ein frühes Chatbot-Programm, und SHRDLU (1968-1970), ein Programm, das mit natürlicher Sprache in einer blockierten Welt interagieren konnte.

1970er – Expertensysteme: Aufkommen von Expertensystemen wie MYCIN (1972), das medizinische Diagnosen und Therapievorschläge liefern konnte.

1980er – Rückpropagierung in Neuronalen Netzen: Die Wiederentdeckung und Verfeinerung des Backpropagation-Algorithmus ermöglichte effektiveres Training tiefer neuronaler Netze.

1997 – Deep Blue besiegt Kasparov: IBMs Schachcomputer Deep Blue schlägt den Weltmeister Garry Kasparov, ein großer Meilenstein für KI im Bereich des Spiels.

2000er – Maschinelles Lernen und Big Data: Fortschritte in der Rechenleistung und die Verfügbarkeit großer Datenmengen führen zu signifikanten Verbesserungen in maschinellen Lernverfahren.

2010er – Durchbruch in Deep Learning: Erfolge von tiefen neuronalen Netzwerken in Bereichen wie Bild- und Spracherkennung. Ein Schlüsselmoment ist 2012, als das neuronale Netzwerk “AlexNet” neue Maßstäbe in der Bilderkennung setzt.

2014 – Entwicklung von GANs: Einführung der Generative Adversarial Networks (GANs) durch Ian Goodfellow et al., was große Fortschritte im Bereich der generativen Modelle bringt.

2016 – AlphaGo besiegt Lee Sedol: Googles AlphaGo schlägt den Weltmeister im Go-Spiel, Lee Sedol, was die Fähigkeiten von KI in komplexen Strategiespielen demonstriert.

2020er – GPT-3 und Sprachmodelle: OpenAI entwickelt GPT-3, ein fortschrittliches Sprachvorhersagemodell, das neue Maßstäbe in der natürlichen Sprachverarbeitung setzt.

2023 – Aktuelle Entwicklungen: Fortlaufende Fortschritte in verschiedenen Bereichen der KI, einschließlich autonomer Fahrzeuge, Gesundheitswesen, natürlicher Sprachverarbeitung und mehr.

Der Turing Test

Der Turing-Test, benannt nach seinem Schöpfer, dem britischen Mathematiker und Computerwissenschaftler Alan Turing, ist ein Kriterium für die Beurteilung der Fähigkeit einer Maschine, intelligentes Verhalten zu zeigen, das vom menschlichen Verhalten nicht zu unterscheiden ist. Turing stellte diesen Test in seinem wegweisenden Artikel “Computing Machinery and Intelligence” von 1950 vor und prägte damit die Grundlage der künstlichen Intelligenz, wie wir sie heute kennen.

Konzept des Tests: Der Test besteht darin, dass ein menschlicher Befrager in natürlicher Sprache mit einem versteckten Gesprächspartner kommuniziert. Dieser Gesprächspartner kann entweder ein Mensch oder eine Maschine (Computer) sein. Der Befrager muss dann entscheiden, ob er mit einer Maschine oder einem Menschen kommuniziert. Wenn der Befrager nicht zuverlässig zwischen dem menschlichen und dem maschinellen Gesprächspartner unterscheiden kann, gilt die Maschine gemäß dem Test als intelligent.

Bedeutung des Tests: Der Turing-Test war revolutionär, weil er einen völlig neuen Ansatz für die Beurteilung von Intelligenz bot, der von der Funktionsweise oder dem Aufbau der Maschine abstrahierte. Statt zu fragen, ob eine Maschine “denkt”, konzentrierte sich Turing auf die beobachtbare Leistung oder das Verhalten der Maschine.

Kritik und Weiterentwicklung: Obwohl der Test ein grundlegendes Konzept in der KI darstellt, ist er im Laufe der Zeit auch kritisiert worden. Einige Kritikpunkte beziehen sich darauf, dass der Test keine tatsächliche Intelligenz misst, sondern lediglich die Fähigkeit einer Maschine, menschliche Konversation nachzuahmen. Zudem berücksichtigt der Test nicht die Fähigkeit zur Problemlösung oder zum kreativen Denken, die oft mit menschlicher Intelligenz assoziiert werden. Trotz dieser Kritik bleibt der Turing-Test ein wichtiger Meilenstein und eine nützliche Abstraktion, um über die Ziele und Herausforderungen der KI-Forschung nachzudenken.

Aktuelle Relevanz: Heute, in einer Zeit, in der KI-Systeme wie Chatbots und virtuelle Assistenten immer ausgefeilter werden, erlangt der Turing-Test neue Relevanz. Während moderne Systeme zunehmend in der Lage sind, den Test in begrenztem Umfang zu bestehen, bleibt die Schaffung einer Maschine, die vollständig und konsistent menschliche Intelligenz imitieren kann, eine Herausforderung und ein Ziel der zukünftigen KI-Forschung.

Bedeutung und Anwendungsbereiche

Die Bedeutung von KI-Modellen in der heutigen Welt kann kaum überbetont werden. Sie sind nicht nur Treiber der technologischen Revolution, sondern haben auch tiefgreifende Auswirkungen auf nahezu jeden Aspekt unseres Lebens und Arbeitens. Die Anwendungen von KI erstrecken sich über zahlreiche Branchen, wobei jede ihre eigenen spezifischen Herausforderungen und Chancen bietet.

- Marketing: Im Marketing revolutionieren KI-Modelle die Art und Weise, wie Unternehmen mit Kunden interagieren und ihre Produkte bewerben. Sie ermöglichen eine präzise Analyse des Verbraucherverhaltens und fördern personalisierte Marketingstrategien. Durch die Auswertung von Kundendaten können KI-Systeme maßgeschneiderte Werbeinhalte erstellen, effektivere Zielgruppensegmentierung vornehmen und die Kundenansprache optimieren. Darüber hinaus unterstützen sie bei der Prognose von Markttrends und Verbraucherpräferenzen.

- Gesundheitswesen: In der Medizin transformieren KI-Modelle die Art und Weise, wie Krankheiten diagnostiziert und behandelt werden. Durch die Analyse von medizinischen Bildern können KI-Systeme beispielsweise Tumore in frühen Stadien erkennen, was entscheidend für die Behandlung sein kann. Weiterhin unterstützen sie in der personalisierten Medizin, indem sie Therapiepläne basierend auf dem genetischen Profil der Patienten vorschlagen.

- Finanzwesen: Im Banken- und Finanzsektor spielen KI-Modelle eine zentrale Rolle bei der Betrugserkennung und Risikobewertung. Sie analysieren Transaktionsmuster, um betrügerische Aktivitäten zu identifizieren, und unterstützen bei der Kreditwürdigkeitsprüfung durch die Auswertung großer Datenmengen.

- Einzelhandel: Im Einzelhandel ermöglichen KI-basierte Systeme personalisierte Einkaufserlebnisse. Sie analysieren das Kaufverhalten und die Präferenzen der Kunden, um individualisierte Empfehlungen zu geben. Zudem optimieren sie die Lieferkette und das Bestandsmanagement.

- Automobilindustrie: Die Automobilindustrie nutzt KI für das autonome Fahren. KI-Modelle sind dabei unverzichtbar für die Verarbeitung der von Sensoren und Kameras erfassten Daten, um Fahrzeuge sicher durch den Verkehr zu steuern.

- Fertigung: In der Fertigungsindustrie verbessern KI-Modelle die Effizienz und Qualität der Produktion. Sie überwachen und analysieren Produktionsprozesse, um Fehler frühzeitig zu erkennen und Ausfallzeiten zu minimieren.

- Energie: Im Energiesektor tragen KI-Systeme dazu bei, die Effizienz von erneuerbaren Energiequellen zu optimieren und den Energieverbrauch zu prognostizieren, was für das Management von Stromnetzen entscheidend ist.

- Bildung: Im Bildungsbereich ermöglichen KI-Modelle spezifisches Lernen, indem sie den Fortschritt der Schüler verfolgen und personalisierte Lernmaterialien anbieten.

- Landwirtschaft: KI findet auch in der Landwirtschaft Anwendung, wo sie beispielsweise bei der Überwachung von Kulturpflanzen, Bodenanalyse und Ertragsvorhersagen hilft.

Diese Beispiele sind nur ein Bruchteil der unzähligen Anwendungen von KI in verschiedenen Branchen. Durch die Kombination von maschinellem Lernen, Big Data und zunehmend leistungsfähigeren Computertechnologien eröffnen sich ständig neue Möglichkeiten. Die Zukunft verspricht noch größere Durchbrüche, da die KI weiterhin neue Bereiche erschließt und bestehende Prozesse revolutioniert.

Trotz dieser beeindruckenden Entwicklungen und Möglichkeiten ist es entscheidend, KI-Systeme kontinuierlich zu überprüfen und zu regulieren. Dies ist aus mehreren Gründen wichtig:

- Ethik und Verantwortlichkeit: KI-Systeme können nur auf der Grundlage der Daten, mit denen sie trainiert wurden, Entscheidungen treffen. Dies kann zu Verzerrungen und unfairen Ergebnissen führen, wenn die Daten voreingenommen sind. Daher ist es wichtig, KI-Modelle auf ethische Grundsätze zu überprüfen und sicherzustellen, dass sie keine diskriminierenden Muster verstärken.

- Sicherheit und Zuverlässigkeit: In kritischen Anwendungen wie dem Gesundheitswesen oder dem autonomen Fahren können Fehler in KI-Systemen schwerwiegende Konsequenzen haben. Eine ständige Überprüfung und Validierung ist erforderlich, um die Sicherheit und Zuverlässigkeit dieser Systeme zu gewährleisten.

- Transparenz und Nachvollziehbarkeit: Es ist wichtig, dass Entscheidungen, die von KI-Systemen getroffen werden, transparent und nachvollziehbar sind. Dies ist besonders in Bereichen wie dem Rechtswesen und der Finanzwelt wichtig, wo Entscheidungen erhebliche Auswirkungen auf das Leben der Menschen haben können.

- Anpassung und Weiterentwicklung: Die Welt verändert sich ständig, und KI-Systeme müssen sich an diese Veränderungen anpassen. Regelmäßige Überprüfungen stellen sicher, dass KI-Modelle aktuell bleiben und sich an neue Gegebenheiten und Anforderungen anpassen.

Die Überwachung und Regulierung von KI ist daher ein wesentlicher Bestandteil ihrer Entwicklung. Sie stellt sicher, dass die Technologie zum Wohle der Gesellschaft eingesetzt wird und gleichzeitig Risiken und unerwünschte Konsequenzen minimiert werden.

Hauptkategorien von KI-Modellen

KI hat sich zu einem zentralen Thema in der heutigen technologiegetriebenen Welt entwickelt, mit einer ständig wachsenden Palette an KI-Tools. Trotz dieser wachsenden Präsenz stellt das Verständnis der Funktionsweise von KI für viele eine Herausforderung dar. Dieser Blogbeitrag zielt darauf ab, ein tieferes Verständnis für KI-Modelle zu vermitteln, ihre Mechanismen zu enthüllen und ihre weitreichenden Auswirkungen auf verschiedene Branchen aufzuzeigen. Zunächst werden wir die Hauptkategorien von KI-Modellen erörtern. Anschließend vertiefen wir uns in spezifischere Modelle und deren Anwendungen. Abschließend beleuchten wir, warum eine eindeutige Zuordnung zu den Hauptkategorien oft komplex ist.

1. Supervised Learning (Überwachtes Lernen):

Überwachtes Lernen ist eine der zentralen Methoden im maschinellen Lernen und spielt eine wesentliche Rolle in der Entwicklung vieler KI-Anwendungen. Bei diesem Ansatz werden Modelle mit einem Datensatz trainiert, der aus Eingabe-Ausgabe-Paaren besteht. Jedes Paar besteht aus einem Eingabedatum (zum Beispiel ein Bild) und einem korrekten Label oder einer Antwort (zum Beispiel die Bezeichnung des Objekts auf dem Bild).

Grundkonzept:

- Beim überwachten Lernen lernt das Modell aus den Trainingsdaten, Muster und Beziehungen zu identifizieren. Das Ziel ist es, eine Funktion zu erstellen, die Eingabedaten auf ihre korrekten Ausgaben abbilden kann. Nach ausreichendem Training sollte das Modell in der Lage sein, korrekte Prognosen oder Klassifikationen für neue, unbekannte Daten zu treffen.

Trainingsprozess:

- Der Trainingsprozess beinhaltet die Anpassung eines Modells, typischerweise eines neuronalen Netzwerks oder eines anderen algorithmischen Modells, um die Beziehung zwischen den Eingabedaten und den Ausgabelabels zu “lernen”. Dies geschieht durch einen iterativen Prozess, bei dem das Modell seine Prognosen mit den tatsächlichen Labels vergleicht und seine Parameter entsprechend anpasst, um die Genauigkeit zu verbessern.

Typische Anwendungen:

- Bilderkennung: Hier werden Modelle darauf trainiert, Objekte, Gesichter oder Szenen in Bildern zu erkennen und zu klassifizieren.

- Spracherkennung: Überwachtes Lernen wird eingesetzt, um Modelle zu trainieren, gesprochene Worte zu erkennen und in Text umzuwandeln.

- E-Mail-Filterung: Zum Beispiel das Erkennen und Filtern von Spam-Nachrichten basierend auf bekannten Merkmalen von Spam-E-Mails.

- Medizinische Diagnose: Modelle, die Krankheitsbilder oder Symptome erkennen und Diagnosevorschläge machen.

Herausforderungen:

- Eine der größten Herausforderungen im überwachten Lernen ist die Notwendigkeit großer Mengen an gelabelten Daten. Das Labeln kann zeitaufwendig und kostspielig sein.

- Überwachtes Lernen ist auch anfällig für Überanpassung (Overfitting), wenn das Modell zu spezifisch auf die Trainingsdaten zugeschnitten ist und nicht gut auf neue Daten generalisiert.

Zukünftige Perspektiven:

- Die Entwicklung effizienterer Methoden zur Datensammlung und -labelung sowie fortgeschrittener Algorithmen, die Überanpassung reduzieren, sind aktuelle Forschungsthemen im Bereich des überwachten Lernens.

2. Unsupervised Learning (Unüberwachtes Lernen):

Unüberwachtes Lernen ist eine andere fundamentale Methode im maschinellen Lernen, bei der Modelle mit Datensätzen trainiert werden, die keine vorher festgelegten Labels oder Antworten haben. Das Ziel von unüberwachtem Lernen ist es, die inhärenten Strukturen und Muster in den Daten selbständig zu erkennen und zu nutzen.

Grundkonzept:

- Im Gegensatz zum überwachten Lernen, wo die Modelle klare Anweisungen durch Labels erhalten, müssen Modelle im unüberwachten Lernen selbst herausfinden, wie die Daten organisiert werden können. Dies kann durch das Identifizieren von Clustern (Gruppen von ähnlichen Datenpunkten), das Auffinden von Ausreißern oder das Entdecken von Zusammenhängen innerhalb der Daten geschehen.

Haupttechniken:

- Clustering: Eine der häufigsten Techniken im unüberwachten Lernen. Ziel ist es, Datenpunkte in Gruppen (Cluster) zu unterteilen, sodass Punkte innerhalb eines Clusters ähnlicher zueinander sind als zu Punkten in anderen Clustern. Beispiele für Clustering-Algorithmen sind K-Means und hierarchisches Clustering.

- Assoziationsanalyse: Dieser Ansatz wird verwendet, um Regeln zu finden, die große Teile der Daten beschreiben, wie zum Beispiel häufige Kombinationen von Produkten in Einkaufstransaktionen.

- Dimensionsreduktion: Verfahren wie die Hauptkomponentenanalyse (PCA) reduzieren die Komplexität der Daten, indem sie sie auf ihre wichtigsten Bestandteile reduzieren.

Typische Anwendungen:

- Marktsegmentierung: Gruppierung von Kunden nach Kaufverhalten oder Präferenzen.

- Anomalieerkennung: Identifizierung von ungewöhnlichen Mustern oder Datenpunkten, die auf Fehler oder Betrug hinweisen könnten.

- Empfehlungssysteme: Entdeckung von Produkten oder Inhalten, die für einen Nutzer interessant sein könnten, basierend auf den Präferenzen ähnlicher Nutzer.

Herausforderungen:

- Eine der größten Herausforderungen im unüberwachten Lernen ist die Interpretation der Ergebnisse, da es keine vordefinierten Antworten oder Labels gibt, die als Leitfaden dienen könnten.

- Die Bestimmung der richtigen Anzahl von Clustern oder die Auswahl der geeigneten Dimensionsreduktionsmethode kann schwierig sein und erfordert oft Expertenwissen.

Zukünftige Perspektiven:

-

- Die Entwicklung von Techniken, die bessere und intuitivere Einblicke in komplexe Daten liefern, steht im Mittelpunkt aktueller Forschungen. Darüber hinaus gibt es Bestrebungen, Methoden des unüberwachten Lernens mit anderen Lernformen zu kombinieren, um die Effektivität und Anwendbarkeit der Modelle zu erhöhen.

3. Reinforcement Learning (Bestärkendes Lernen):

Reinforcement Learning (RL) ist ein bedeutender Bereich des maschinellen Lernens, bei dem ein Agent lernt, wie er sich in einer Umgebung verhalten soll, um ein bestimmtes Ziel zu erreichen. Im Gegensatz zu überwachtem und unüberwachtem Lernen, bei denen die Daten bereits vorliegen, interagiert der Agent beim RL aktiv mit seiner Umgebung, um die besten Handlungen zu erlernen.

Grundkonzept:

- Im Kern des RL steht das Konzept von Belohnungen und Strafen. Der Agent trifft Entscheidungen (Aktionen) und erhält daraufhin Feedback in Form von Belohnungen oder Strafen. Das Ziel des Agenten ist es, eine Strategie (Policy) zu entwickeln, die die kumulierten Belohnungen über die Zeit maximiert.

- RL ist besonders geeignet für Probleme, bei denen eine klare Rückmeldung über die Richtigkeit einer Aktion nicht sofort verfügbar ist, sondern sich erst aus den daraus resultierenden Konsequenzen ergibt.

Hauptkomponenten:

- Agent: Das lernende Modell, das Aktionen ausführt.

- Umwelt (Environment): Der Kontext, in dem der Agent handelt.

- Belohnungen (Rewards): Rückmeldungen von der Umwelt, die die Qualität einer Aktion bewerten.

- Policy: Die Strategie des Agenten, die bestimmt, welche Aktion in einem bestimmten Zustand ausgeführt werden soll.

Typische Anwendungen:

- Spiele: Wie das Schachspiel von Deep Blue oder AlphaGo von DeepMind, die RL nutzen, um Strategien für komplexe Spiele zu entwickeln.

- Robotik: RL wird eingesetzt, um Robotern beizubringen, Aufgaben durch Trial-and-Error zu erlernen.

- Autonomes Fahren: Entwicklung von Steuerungssystemen für selbstfahrende Autos.

Herausforderungen:

- Eine der größten Herausforderungen im RL ist die Balance zwischen Erkundung (neue Strategien ausprobieren) und Ausbeutung (bewährte Strategien nutzen). Zu viel Erkundung kann zu ineffizientem Lernen führen, während zu viel Ausbeutung die Entdeckung optimaler Strategien verhindern kann.

- RL erfordert oft eine große Menge an Interaktionen mit der Umgebung, was rechenintensiv und zeitaufwendig sein kann.

Zukünftige Perspektiven:

- Die Forschung konzentriert sich auf effizientere Lernmethoden, die weniger Interaktionen benötigen und schneller konvergieren. Auch die Integration von RL mit anderen Lernmethoden, wie dem tiefen Lernen, ist ein aktives Forschungsgebiet.

4. Deep Learning (Tiefes Lernen):

Deep Learning ist ein hochspezialisierter und fortschrittlicher Bereich des maschinellen Lernens, der sich durch den Einsatz tiefer (d.h. vielschichtiger) neuronaler Netzwerke auszeichnet. Diese Technologie hat zu bedeutenden Durchbrüchen in der Fähigkeit von Computern geführt, komplexe, menschenähnliche Aufgaben auszuführen, insbesondere in den Bereichen Bild- und Spracherkennung.

Grundkonzept:

- Deep Learning-Modelle bestehen aus mehreren Verarbeitungsebenen (Schichten), die Daten auf zunehmend abstrakte Weise verarbeiten. Jede Schicht des Netzwerks transformiert ihre Eingabe und leitet das Ergebnis an die nächste Schicht weiter. Dies ermöglicht es dem Modell, komplexe Muster in großen Datenmengen zu erkennen und zu lernen.

- Diese Netzwerke ahmen in gewisser Weise die Art und Weise nach, wie das menschliche Gehirn Informationen verarbeitet, obwohl die genaue Funktionsweise von neuronalen Netzwerken und dem menschlichen Gehirn sehr unterschiedlich ist.

Haupttypen von Deep Learning-Modellen:

- Convolutional Neural Networks (CNNs): Besonders effektiv in der Bild- und Videoverarbeitung. Sie können Merkmale aus Bildern erkennen und werden in Anwendungen wie Gesichtserkennung und automatischer Bildklassifizierung eingesetzt.

- Recurrent Neural Networks (RNNs) und Long Short-Term Memory Networks (LSTMs): Geeignet für die Verarbeitung von Sequenzdaten wie Text oder Zeitreihen. Sie werden häufig in Spracherkennungssystemen und bei der maschinellen Übersetzung verwendet.

Typische Anwendungen:

- Automatische Bilderkennung: Fähigkeit, Objekte, Personen, Szenen und Aktionen in Bildern und Videos zu identifizieren.

- Natürliche Sprachverarbeitung: Übersetzen von Texten, Beantworten von Fragen und Verstehen natürlicher Sprache.

- Selbstfahrende Autos: Verarbeitung und Interpretation von Sensor- und Bilddaten zur Navigation.

Herausforderungen:

- Eines der Hauptprobleme im Deep Learning ist der Bedarf an großen Mengen an Trainingsdaten, um effektiv zu funktionieren.

- Deep Learning-Modelle sind oft als “Black Boxes” kritisiert worden, da ihre Entscheidungsfindungsprozesse schwer nachvollziehbar sind. Dies hat zur Forderung nach mehr Transparenz und Erklärbarkeit in KI-Systemen geführt.

Zukünftige Perspektiven:

- Die Forschung im Bereich Deep Learning konzentriert sich auf die Entwicklung effizienterer und weniger datenhungriger Modelle sowie auf die Verbesserung der Transparenz und Erklärbarkeit der Modelle. Ein weiterer Schwerpunkt liegt auf der Integration von Deep Learning mit anderen KI-Technologien, um noch leistungsfähigere und vielseitigere Systeme zu schaffen.

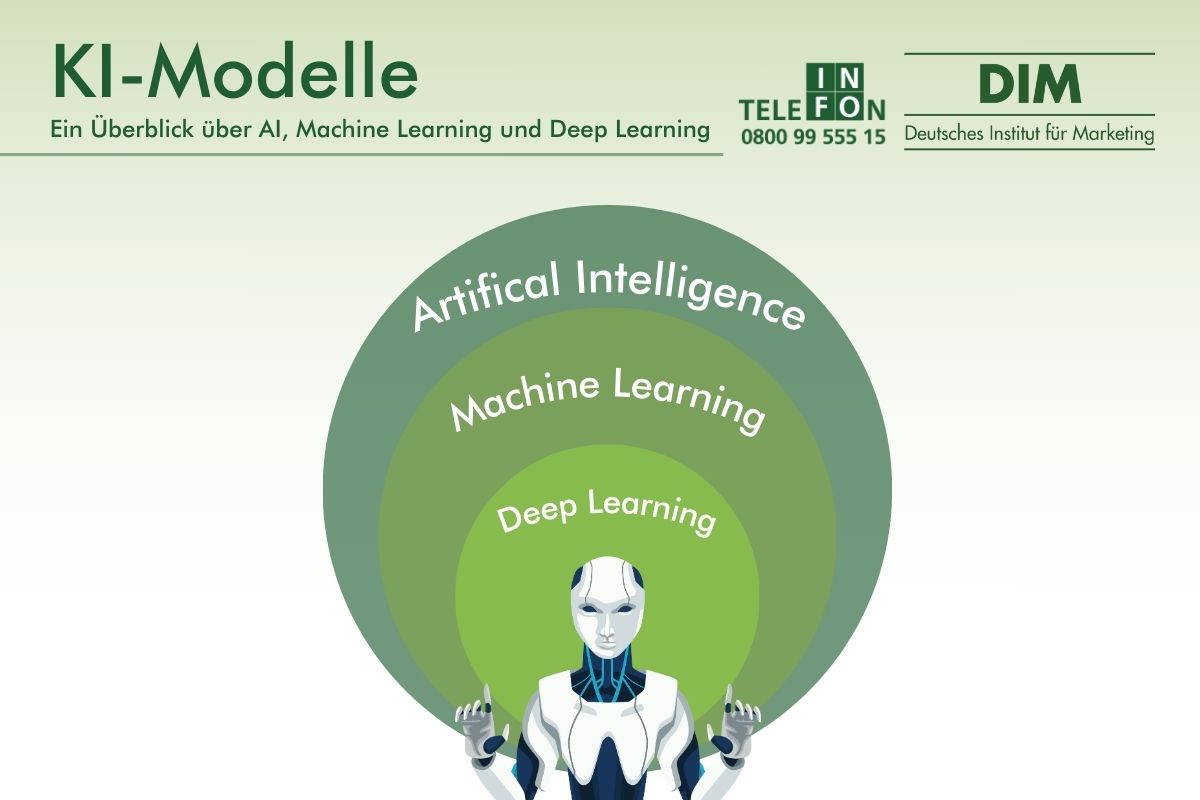

Supervised, Unsupervised und Reinforcement Learning sind Methoden des Machine Learning, das wiederum ein Teilbereich der Artificial Intelligence (AI) ist. Deep Learning ist eine spezialisierte Technik, die unter das Dach des Machine Learning fällt und alle drei genannten Methoden (Supervised, Unsupervised, Reinforcement) beinhalten kann.

Generative Modelle

Generative KI-Modelle sind eine faszinierende und schnell wachsende Kategorie innerhalb der künstlichen Intelligenz, die darauf abzielt, neue Daten zu erzeugen, die ähnliche Eigenschaften wie ein gegebener Datensatz aufweisen. Diese Modelle sind in der Lage, komplexe Datenstrukturen zu lernen und zu imitieren, was zu einer Vielzahl von innovativen Anwendungen führt.

Grundkonzept:

- Generative Modelle lernen die Verteilung und die Strukturen innerhalb eines Trainingsdatensatzes. Anstatt eine direkte Antwort oder Klassifikation vorherzusagen (wie es bei diskriminativen Modellen der Fall ist), generieren sie Daten, die den Trainingsdaten ähnlich sind. Dies kann Text, Bilder, Musik, Sprache und vieles mehr umfassen.

Haupttypen und Beispiele:

- Generative Adversarial Networks (GANs): Eine der bekanntesten Arten generativer Modelle. GANs bestehen aus zwei Netzwerken: dem Generator, der Daten erzeugt, und dem Diskriminator, der zwischen echten und vom Generator erzeugten Daten unterscheidet. Durch diesen Wettbewerb lernen beide Netzwerke, ihre Leistung zu verbessern.

- Variational Autoencoders (VAEs): Diese Modelle sind besonders gut in der Codierung von Eingabedaten in eine komprimierte Darstellung und anschließendem Generieren von Daten aus dieser Darstellung. Sie werden häufig in der Bildverarbeitung und -rekonstruktion eingesetzt.

- Convolutional Neural Networks (CNNs): Ein weiterer wichtiger Haupttyp generativer Modelle, insbesondere in Bezug auf die Bildgenerierung. CNNs sind spezialisierte neuronale Netzwerke, die in der Lage sind, räumliche Merkmale in Bildern zu erkennen und zu extrahieren. Klassische neuronale Netzwerke verwenden voll- oder teilvermaschte Neuronen, die sich über mehrere Ebenen erstrecken. Die Verbindungen zwischen diesen Schichten sind jedoch so zahlreich, dass nur leistungsstarke Computer damit umgehen können. Dies stößt insbesondere bei Aufgaben wie der Bildgenerierung an Grenzen. Convolutional Neural Networks (CNNs) hingegen bestehen aus verschiedenen Schichten, von denen wir sie hier einfachheitshalber als Schicht A und B bezeichnen. Die dritte Schicht ist eine vollständig vermaschte Schicht. Schicht A und B sind lokal vermaschte Teilnetze, was bedeutet, dass die Anzahl der Verbindungen auch bei großen Datenmengen begrenzt bleibt und in einem überwindbaren Rahmen bleibt. Die vollständig vermaschte Schicht bildet logischerweise den Abschluss des Netzwerks.

Anwendungen:

- Bildgenerierung und -bearbeitung: Erzeugen neuer Bilder, die realistisch aussehen, oder Ändern bestehender Bilder (z.B. Gesichtsalterung).

- Texterzeugung: Erstellen von kohärenten und sinnvollen Texten, beispielsweise für kreative Schreibzwecke oder Chatbots.

- Stiltransfer: Übertragen eines bestimmten Stils von einem Bild auf ein anderes, wie z.B. das Anwenden des Stils eines berühmten Gemäldes auf eine Fotografie.

Herausforderungen:

- Eines der Hauptprobleme bei generativen Modellen ist die Qualität der generierten Daten. Sie können manchmal unrealistische oder unzusammenhängende Ergebnisse produzieren.

- Eine weitere Herausforderung ist die ethische Dimension: Die Fähigkeit, realistische Medien zu erzeugen, wirft Fragen bezüglich Urheberrecht, Authentizität und Missbrauchspotenzial auf.

Zukunftsperspektiven:

- Forschung und Entwicklung in diesem Bereich konzentrieren sich auf die Verbesserung der Genauigkeit und Realismus der generierten Daten sowie auf die Schaffung von Modellen, die ethische und rechtliche Standards berücksichtigen.

Generative Modelle repräsentieren eine bemerkenswerte Entwicklung in der KI, die es ermöglicht, neue, realistische Daten basierend auf vorhandenen Mustern zu erzeugen. Diese Modelle haben sich in einer Vielzahl von Anwendungen als besonders leistungsfähig erwiesen, von der Erzeugung künstlerischer Bilder bis hin zur Simulation komplexer Systeme, und bieten faszinierende Möglichkeiten für kreatives und innovatives maschinelles Lernen.

Beispiel:

DeepArt / Deep Dream Generator

- Funktionsweise: DeepArt verwendet generative KI-Modelle, insbesondere eine Form des Stiltransfers, die von einem Convolutional Neural Network (CNN) ermöglicht wird. Nutzer können ein Bild hochladen und einen künstlerischen Stil auswählen (oder ein weiteres Bild hochladen, das diesen Stil repräsentiert). Das Tool generiert dann eine neue Version des Originalbildes, die im Stil des gewählten Kunstwerks gestaltet ist.

- Anwendungsbereich: DeepArt ist besonders beliebt für die kreative Bildbearbeitung, da es ermöglicht, alltägliche Fotos in Kunstwerke umzuwandeln, die bekannten Gemälden oder spezifischen Kunststilen ähneln.

- Technologie: Die zugrunde liegende Technologie basiert auf Forschungsarbeiten zum neuronalen Stiltransfer, bei dem tiefe neuronale Netzwerke trainiert werden, um den Stil eines Bildes (z.B. die Pinselstriche eines Gemäldes) zu erfassen und auf ein anderes Bild anzuwenden.

Diskriminative Modelle

Diskriminative Modelle, auch als unterscheidende Modelle bekannt, sind ein grundlegender Bestandteil vieler KI-Anwendungen. Im Gegensatz zu generativen Modellen, die darauf abzielen, Daten zu generieren, konzentrieren sich diskriminative Modelle darauf, zwischen verschiedenen Klassen oder Kategorien von Daten zu unterscheiden.

Grundkonzept:

- Diskriminative Modelle lernen die Grenze oder den Unterschied zwischen verschiedenen Kategorien von Daten. Sie tun dies, indem sie direkt aus den Eingabedaten auf das entsprechende Label (oder Ausgabe) schließen, ohne zu versuchen, die Verteilung der Eingabedaten selbst zu modellieren.

- Ein typisches Beispiel ist die Klassifizierung, bei der das Modell lernt, Eingabedaten (wie Bilder oder Texte) in definierte Kategorien einzuordnen.

Haupttypen und Beispiele:

- Support Vector Machines (SVMs): Eine klassische Technik im maschinellen Lernen, die besonders effektiv für kleinere Datensätze ist. SVMs finden die beste Grenze (oder Hyperplane) zwischen den verschiedenen Klassen von Daten.

- Logistische Regression: Ein weiteres traditionelles Modell, das häufig für binäre Klassifizierungsprobleme verwendet wird, wie z.B. das Vorhersagen, ob eine E-Mail Spam ist oder nicht.

Anwendungen:

- E-Mail-Spam-Erkennung: Unterscheidung zwischen Spam und Nicht-Spam-E-Mails.

- Kreditwürdigkeitsprüfung: Vorhersage, ob ein Kreditnehmer wahrscheinlich einen Kredit zurückzahlen wird oder nicht.

- Medizinische Diagnose: Klassifizierung von Patientendaten, um festzustellen, ob eine Krankheit vorliegt oder nicht.

Herausforderungen:

- Eine der Herausforderungen bei diskriminativen Modellen ist der Umgang mit ungleich verteilten Daten (wie bei unausgewogenen Klassen in der Klassifizierung).

- Ein weiteres Problem kann das Überanpassen (Overfitting) sein, bei dem das Modell zu spezifisch auf die Trainingsdaten zugeschnitten ist und nicht gut auf neue Daten generalisiert.

Zukunftsperspektiven:

- Die Weiterentwicklung diskriminativer Modelle fokussiert auf verbesserte Generalisierungsfähigkeiten und Effizienz bei der Handhabung großer und komplexer Datensätze. Es wird auch an der Kombination mit anderen KI-Techniken gearbeitet, um ihre Leistungsfähigkeit und Anwendbarkeit weiter zu verbessern.

Diskriminative Modelle repräsentieren eine bedeutende Entwicklung in der KI, die es ermöglicht, vorhandene Daten zu analysieren und Muster zu identifizieren, um fundierte Entscheidungen zu treffen oder Klassifikationen vorzunehmen. Diese Modelle haben sich in einer breiten Palette von Anwendungen als äußerst leistungsfähig erwiesen, von der Spracherkennung bis zur Bilderkennung, und bieten vielfältige Möglichkeiten für datengetriebene Analysen und präzises maschinelles Lernen.

Beispiel:

Scikit-learn für SVMs und Logistische Regression

- Funktionsweise: Scikit-learn ist eine beliebte Open-Source-Machine-Learning-Bibliothek in Python, die eine Vielzahl von Algorithmen für datenwissenschaftliche Aufgaben bietet. Es enthält effiziente Implementierungen von SVMs und logistischer Regression, zwei klassischen diskriminativen Modellen.

- Anwendungsbereich: Mit Scikit-learn können Nutzer komplexe Klassifizierungsprobleme angehen, beispielsweise die Unterscheidung zwischen verschiedenen Arten von Objekten in einem Bild oder die Vorhersage von Kategorien basierend auf Textdaten.

- Technologie: Die Bibliothek bietet eine benutzerfreundliche Schnittstelle, die es ermöglicht, Modelle mit wenigen Zeilen Code zu trainieren und zu evaluieren. Es unterstützt auch fortgeschrittene Maschinenlernkonzepte wie Cross-Validation, Hyperparameter-Tuning und mehr.

Hybride Modelle

Hybride Modelle in der KI sind Ansätze, die verschiedene Arten von Lern- und KI-Methoden kombinieren, um von den Stärken jeder einzelnen Methode zu profitieren. Diese Modelle zielen darauf ab, die Grenzen einzelner Ansätze zu überwinden, indem sie verschiedene Techniken in einem System integrieren.

Grundkonzept:

- Der Kerngedanke hinter hybriden Modellen ist die Erkenntnis, dass kein einzelner KI-Ansatz alle Probleme optimal lösen kann. Indem man verschiedene Techniken kombiniert, kann man robustere, flexiblere und effizientere Lösungen schaffen.

- Diese Modelle können Elemente des überwachten und unüberwachten Lernens, des Reinforcement Learning, des tiefen Lernens und anderer KI-Techniken wie regelbasierte Systeme oder Expertensysteme umfassen.

Haupttypen und Beispiele:

- Neuro-symbolische KI: Eine Kombination aus neuronalen Netzen (Deep Learning) und symbolischer KI (regelbasierte Systeme). Diese Modelle nutzen die Fähigkeit neuronaler Netze, Muster zu erkennen, und ergänzen sie mit der Präzision und Klarheit symbolischer Systeme.

- Deep Reinforcement Learning: Verbindet Prinzipien des Deep Learning mit Reinforcement Learning, um Agenten zu schaffen, die in komplexen, sensorischen Umgebungen lernen und agieren können.

Anwendungen:

- Robotersteuerung: Kombination von sensorischer Datenverarbeitung (Deep Learning) mit Entscheidungsfindungsstrategien (Reinforcement Learning).

- Komplexe Entscheidungsfindung: Integration von regelbasierten Systemen mit lernbasierten Modellen zur Verbesserung der Entscheidungsfindung in Bereichen wie Finanzen oder Gesundheitswesen.

Herausforderungen:

- Einer der Hauptkomplikationen bei der Entwicklung hybrider Modelle ist die Integration verschiedener Systeme, die möglicherweise unterschiedliche Datenformate, Verarbeitungsstile und Leistungsziele haben.

- Ein weiteres Problem kann die Komplexität des resultierenden Systems sein, sowohl in Bezug auf die Entwicklung als auch auf die Wartung.

Zukunftsperspektiven:

- Hybride Modelle sind ein aktives Forschungsgebiet, da sie das Potenzial haben, KI-Lösungen zu schaffen, die realistischer, anpassungsfähiger und effektiver sind. Es wird erwartet, dass zukünftige Entwicklungen zu noch nahtloseren und leistungsstärkeren Integrationen verschiedener KI-Techniken führen werden.

Hybride Modelle stehen an der Schnittstelle verschiedener KI-Disziplinen und kombinieren Methoden wie überwachtes, unüberwachtes und verstärkendes Lernen. Diese integrative Herangehensweise ermöglicht es, die Stärken einzelner Modelle zu vereinen und bietet somit eine vielseitige Lösung für komplexe Probleme, die eine multifacettierte Herangehensweise erfordern.

Beispiel:

TensorFlow für hybride Modelle:

- Funktionsweise: TensorFlow ist eine Open-Source-Softwarebibliothek für maschinelles Lernen, die eine breite Palette von Werkzeugen für den Bau von KI-Modellen bietet. Es unterstützt sowohl Deep Learning-Modelle als auch traditionelle ML-Modelle.

- Anwendungsbereich: Mit TensorFlow können Entwickler komplexe Modelle erstellen, die Elemente von Deep Learning, klassischem maschinellem Lernen und sogar regelbasierten Komponenten integrieren. Beispielsweise könnte man ein neuronales Netzwerk (Deep Learning) mit einem Entscheidungsbaum (traditionelles ML) kombinieren, um von den Stärken beider Ansätze zu profitieren.

- Technologie: TensorFlow bietet Flexibilität und Modularität, sodass Entwickler unterschiedliche KI-Techniken in einem kohärenten System vereinen können. Es ermöglicht auch die Integration mit anderen Google-Tools und -Diensten, was die Entwicklung leistungsfähiger, hybrider KI-Anwendungen erleichtert.

TensorFlow ist besonders nützlich für Forscher und Entwickler, die experimentieren und die Grenzen der KI-Technologie erweitern möchten, einschließlich der Entwicklung hybrider Modelle, die mehrere KI-Techniken miteinander verknüpfen.

Evolutionäre Algortihmen

Evolutionäre Algorithmen (EAs) sind eine Familie von Algorithmen für das Optimierungsproblem, die von den Prozessen der natürlichen Evolution inspiriert sind. Sie verwenden Mechanismen, die der natürlichen Selektion und genetischen Variation ähneln, um optimale oder nahezu optimale Lösungen für komplexe Probleme zu finden.

Grundkonzept:

- Der grundlegende Prozess in einem evolutionären Algorithmus beinhaltet die Erzeugung einer Population von Individuen (Lösungen), die dann entsprechend ihrer Anpassungsfähigkeit (Fitness) an die Umgebung bewertet werden. Die am besten angepassten Individuen werden ausgewählt, um die nächste Generation zu erzeugen, wobei genetische Operatoren wie Kreuzung (Crossover) und Mutation angewendet werden.

Haupttypen:

- Genetische Algorithmen (GAs): Die am häufigsten verwendeten evolutionären Algorithmen (EA). GAs verwenden eine codierte Form des Problems (oft als “Chromosomen” bezeichnet), führen Kreuzung und Mutation durch und wenden eine Fitnessfunktion an, um die besten Lösungen auszuwählen.

- Genetische Programmierung (GP): Eine Variante der genetischen Algorithmen, die darauf abzielt, Computerprogramme als Lösung für ein Problem zu entwickeln.

Anwendungen:

- Optimierungsprobleme: EAs werden häufig in Bereichen eingesetzt, in denen herkömmliche Optimierungstechniken aufgrund der Komplexität des Problems oder des Lösungsraums nicht praktikabel sind.

- Automatisches Design: Erstellung von komplexen Strukturen oder Systemen, wie z.B. automatisiertes Design von Computerchips.

- Künstliche Lebenssimulationen: Erforschung von Entwicklungsprozessen und Verhaltensmustern durch simulierte evolutionäre Prozesse.

Herausforderungen:

- Eine Herausforderung bei der Verwendung von EAs ist die Wahl der richtigen genetischen Operatoren und Parameter, die einen signifikanten Einfluss auf die Leistung des Algorithmus haben können.

- EAs können auch ineffizient sein, wenn es um sehr große oder besonders komplexe Probleme geht, da sie viele Generationen benötigen können, um eine zufriedenstellende Lösung zu finden.

Zukunftsperspektiven:

- Die Forschung konzentriert sich auf die Entwicklung effizienterer evolutionärer Algorithmen, die schneller konvergieren und in der Lage sind, mit noch größeren und komplexeren Problemen umzugehen. Es gibt auch Bestrebungen, EAs mit anderen KI- und ML-Techniken zu kombinieren, um ihre Effektivität zu erhöhen.

Evolutionäre Algorithmen bieten einen innovativen Ansatz in der KI, der von den Mechanismen der natürlichen Evolution inspiriert ist. Diese Algorithmen sind besonders nützlich für Optimierungsprobleme, da sie durch iterative Anpassung und Auswahl von Lösungen effektive Ergebnisse in komplexen Suchräumen erzielen können.

Beispiel:

DEAP (Distributed Evolutionary Algorithms in Python)

- Funktionsweise: DEAP ist eine flexible und benutzerfreundliche Open-Source-Bibliothek, die speziell für die Arbeit mit evolutionären Algorithmen, wie genetischen Algorithmen (GAs) und genetischer Programmierung (GP), entwickelt wurde. Sie bietet die Tools zur Erstellung eigener evolutionärer Algorithmen mit einer Vielzahl anpassbarer Komponenten.

- Anwendungsbereich: DEAP wird in der Forschung und Entwicklung für Optimierungsprobleme eingesetzt. Es ermöglicht Nutzern, komplexe Optimierungsprobleme zu lösen, die von der Ressourcenzuweisung bis zur Automatisierung des Designs reichen können.

- Technologie: DEAP zeichnet sich durch seine Modularität und Flexibilität aus. Es erlaubt Nutzern, eigene Typen von Individuen und Fortpflanzungsmechanismen zu definieren und unterstützt parallele Verarbeitung, um die Effizienz zu erhöhen.

Transfer Learning Modelle

Transfer Learning ist eine fortschrittliche Technik im maschinellen Lernen, die darauf abzielt, Wissen von einem Bereich (Quelldomäne) auf einen anderen Bereich (Zieldomäne) zu übertragen. Diese Methode ist besonders nützlich, wenn es an ausreichenden Trainingsdaten in der Zieldomäne mangelt.

Grundkonzept:

- Beim Transfer Learning wird ein Modell, das bereits für eine bestimmte Aufgabe oder Domäne trainiert wurde, angepasst, um eine ähnliche, aber unterschiedliche Aufgabe zu lösen. Dieser Ansatz nutzt die Erkenntnis, dass bestimmte Merkmale oder Muster in den Daten universell und über verschiedene Aufgaben hinweg anwendbar sind.

- Ein typisches Beispiel ist ein Deep Learning-Modell, das auf einem umfangreichen Datensatz trainiert wurde und dessen erlernte Merkmale oder Netzwerkschichten dann auf ein verwandtes Problem mit weniger Daten angewendet werden.

Haupttypen und Beispiele:

- Feature-Based Transfer Learning: Übertragung von erlernten Merkmalen (z.B. aus den ersten Schichten eines CNN) auf ein neues Modell.

- Fine-Tuning: Anpassung der Gewichte eines bereits trainierten Modells geringfügig für eine neue Aufgabe.

- Pre-trained Modelle: Nutzung vortrainierter Modelle (wie BERT für Text oder ResNet für Bilder) als Ausgangspunkt für eine Vielzahl von Anwendungen.

Anwendungen:

- Bilderkennung: Anpassung eines auf umfangreichen Bilddatensätzen vortrainierten Modells für spezialisierte Bilderkennungsaufgaben.

- Sprachverarbeitung: Verwendung von auf großen Textkorpora trainierten Modellen für spezifische NLP-Aufgaben wie Sentiment-Analyse oder Textklassifikation.

- Medizinische Bildgebung: Anwendung von in allgemeinen Bilderkennungsaufgaben trainierten Modellen auf spezifische medizinische Diagnoseaufgaben.

Herausforderungen:

- Eine Herausforderung beim Transfer Learning ist die Sicherstellung, dass die Quell- und Zieldomänen ausreichend ähnlich sind, damit das Wissen effektiv übertragen werden kann.

- Ein weiteres Problem kann das Risiko des Overfitting sein, insbesondere wenn das Modell zu stark auf die Quelldaten zugeschnitten ist.

Zukunftsperspektiven:

- Die Forschung im Bereich Transfer Learning konzentriert sich auf die Entwicklung von Methoden, die eine noch effektivere und flexiblere Übertragung von Wissen zwischen unterschiedlichen Aufgaben und Domänen ermöglichen. Ein besonderer Fokus liegt auf der Übertragbarkeit von Modellen auf Aufgaben, die sich deutlich von den ursprünglichen Trainingsaufgaben unterscheiden.

Transfer Learning Modelle revolutionieren den Ansatz des maschinellen Lernens, indem sie Wissen und Fähigkeiten von einer Aufgabe auf eine andere übertragen. Dieser Ansatz erweist sich als besonders wertvoll in Szenarien mit begrenzten Datenmengen, da er es ermöglicht, auf bereits erlernten Erkenntnissen aufzubauen und effizienter zu neuen Lösungen zu gelangen.

Beispiel:

TensorFlow Hub

- Funktionsweise: TensorFlow Hub ist eine Bibliothek und Plattform, die eine Sammlung von vortrainierten Modellen zur Verfügung stellt, die für Transfer Learning verwendet werden können. Diese Modelle decken eine Vielzahl von Anwendungen ab, von Bild- und Textverarbeitung bis hin zu komplexen Problemstellungen.

- Anwendungsbereich: Mit TensorFlow Hub können Entwickler und Forscher auf vortrainierte Modelle zugreifen und diese für ihre spezifischen Projekte anpassen, was Zeit und Ressourcen spart. Es ist besonders nützlich, wenn man schnell Prototypen erstellen oder mit hochmodernen Modellen experimentieren möchte.

- Technologie: Die Plattform ermöglicht es Benutzern, vortrainierte Modellkomponenten (sogenannte “Module”) in ihre TensorFlow-Anwendungen zu integrieren. Diese Module können ganze Modelle, Modellkomponenten oder Feature-Vektoren umfassen, die leicht in neue Modelle integriert werden können.

Explainable AI Modelle

Explainable AI (XAI) bezieht sich auf Methoden und Techniken in der KI, die darauf abzielen, die Funktionsweise und Entscheidungen von KI-Modellen transparent und verständlich zu machen. Angesichts der wachsenden Komplexität moderner KI-Systeme, insbesondere im Bereich des Deep Learning, ist XAI entscheidend für die Vertrauensbildung und ethische Anwendung von KI.

Grundkonzept:

- XAI versucht, die oft als “Black Box” angesehenen KI-Modelle zu öffnen, indem es Einblicke in ihre Entscheidungsfindung bietet. Dies ist wichtig, um sicherzustellen, dass KI-Entscheidungen nachvollziehbar, fair und vertrauenswürdig sind.

- Explainable AI ist besonders relevant in Bereichen, in denen Entscheidungen große Auswirkungen auf Menschen haben können, wie im Gesundheitswesen, im Finanzwesen oder in der Justiz.

Hauptmethoden und -techniken:

- Feature Importance: Ermittlung, welche Eingabefaktoren am meisten zur Entscheidung eines Modells beitragen.

- Visualisierungstechniken: Grafische Darstellungen der Funktionsweise von Modellen, insbesondere bei neuronalen Netzen.

- Lokale Erklärungsmodelle: Techniken wie LIME (Local Interpretable Model-Agnostic Explanations) oder SHAP (SHapley Additive exPlanations), die erklären, warum ein Modell eine bestimmte Entscheidung für eine bestimmte Eingabe getroffen hat.

Anwendungen:

- Medizinische Diagnose: Erklärung der Gründe, warum ein KI-System eine bestimmte Diagnose stellt, was für Ärzte und Patienten wichtig ist.

- Kreditentscheidungen: Nachvollziehbarkeit der Faktoren, die zu einer Kreditgenehmigung oder -ablehnung führen.

Herausforderungen:

- Die Herausforderung bei XAI liegt in der Balance zwischen Leistungsfähigkeit der Modelle und ihrer Erklärbarkeit. Hochkomplexe Modelle, die sehr genaue Vorhersagen treffen, sind oft weniger transparent.

- Eine weitere Herausforderung ist die Entwicklung von Erklärungsmethoden, die sowohl technisch präzise als auch für Nicht-Experten verständlich sind.

Zukunftsperspektiven:

- Die Weiterentwicklung von XAI zielt darauf ab, effektivere und benutzerfreundlichere Erklärungswerkzeuge zu entwickeln, die die Akzeptanz und Vertrauenswürdigkeit von KI-Systemen in der Gesellschaft erhöhen. Es wird auch erwartet, dass regulatorische Entwicklungen mehr Transparenz von KI-Systemen fordern werden.

Explainable AI Modelle stellen einen wichtigen Fortschritt in der KI dar, indem sie die Funktionsweise komplexer KI-Systeme transparent und nachvollziehbar machen. Diese Transparenz ist entscheidend für die Schaffung von Vertrauen und das Verständnis der Entscheidungsprozesse von KI, insbesondere in kritischen Anwendungsbereichen wie Medizin und Finanzen.

Beispiel:

LIME (Local Interpretable Model-Agnostic Explanations)

- Funktionsweise: LIME ist ein Tool, das darauf abzielt, die Vorhersagen von komplexen KI-Modellen zu erklären. Es tut dies, indem es lokale Approximationen um die Vorhersage herum erstellt und analysiert, wie verschiedene Eingabefaktoren die Vorhersage beeinflussen.

- Anwendungsbereich: LIME kann mit jedem Klassifizierungs- oder Regressionsmodell verwendet werden und ist besonders nützlich, um Einblicke in “Black Box”-Modelle wie tiefe neuronale Netze oder komplexe Ensemble-Modelle zu gewinnen.

- Technologie: Das Tool arbeitet, indem es zunächst eine Vorhersage auswählt, die erklärt werden soll. Dann erzeugt es eine Menge von simulierten Datenpunkten in der Nähe der Ausgangsdaten und ermittelt, wie sich Änderungen in diesen Daten auf die Vorhersage auswirken. Anhand dieser Informationen erstellt es ein einfaches Modell, das die Vorhersage in dieser lokalen Umgebung erklärt.

LIME ist auf Plattformen wie GitHub verfügbar, wo Nutzer den Code einsehen, herunterladen und zur Weiterentwicklung beitragen können.

Ensemble-Modelle

Ensemble-Modelle sind eine fortgeschrittene Technik im maschinellen Lernen, bei der mehrere Lernalgorithmen kombiniert werden, um präzisere und robustere Prognosen zu erzielen, als es mit einzelnen Modellen möglich wäre. Sie basieren auf der Idee, dass die Kombination mehrerer Modelle oft zu besseren Ergebnissen führt.

Grundkonzept:

- Der Kerngedanke von Ensemble-Modellen ist, dass die Kombination der Prognosen mehrerer Modelle oft zu höherer Genauigkeit und Stabilität führt. Dies wird erreicht, indem die Schwächen eines Modells durch die Stärken eines anderen ausgeglichen werden.

- Es gibt verschiedene Methoden, um Ensembles zu erstellen, wobei die Hauptansätze “Bagging”, “Boosting” und “Stacking” sind.

Haupttypen und Beispiele:

- Random Forest: Ein typisches Beispiel für ein Bagging-Modell. Es kombiniert die Prognosen mehrerer dekorrelierter Entscheidungsbäume, um die Genauigkeit und Robustheit zu erhöhen.

- Gradient Boosting: Ein populäres Boosting-Modell, das sequenziell schwache Modelle (oft Entscheidungsbäume) aufbaut, wobei jedes Modell versucht, die Fehler des vorherigen zu korrigieren.

Anwendungen:

- Kreditrisikobewertung: Verwendung von Ensemble-Methoden zur genaueren Prognose von Kreditrisiken.

- Krankheitsdiagnose: Kombination verschiedener diagnostischer Modelle zur Verbesserung der Genauigkeit und Zuverlässigkeit.

Herausforderungen:

- Eine Herausforderung bei der Verwendung von Ensemble-Modellen ist deren Komplexität und Rechenintensität, insbesondere bei großen Datensätzen.

- Ein weiteres Problem kann die Interpretierbarkeit sein, da die Kombination mehrerer Modelle oft zu einer “Black Box” führen kann, in der die einzelnen Beiträge schwer zu unterscheiden sind.

Zukunftsperspektiven:

- Die Forschung konzentriert sich auf die Entwicklung effizienterer und transparenterer Ensemble-Methoden. Ein weiterer Schwerpunkt liegt auf der Kombination von Ensemble-Modellen mit anderen fortschrittlichen Techniken wie Deep Learning.

Ensemble-Modelle sind eine mächtige Technik im maschinellen Lernen, die auf der Synergie mehrerer Lernalgorithmen basiert. Sie werden in einer Vielzahl von Anwendungen eingesetzt und sind dafür bekannt, die Leistungsfähigkeit und Genauigkeit von Vorhersagemodellen signifikant zu verbessern.

Beispiel:

XGBoost (eXtreme Gradient Boosting)

- Funktionsweise: XGBoost ist eine leistungsfähige Open-Source-Implementierung des Gradient Boosting-Algorithmus. Es ist bekannt für seine Effizienz, Leistungsfähigkeit und Flexibilität.

- Anwendungsbereich: XGBoost wird häufig in maschinellen Lernwettbewerben und in der Industrie für eine Vielzahl von Klassifizierungs- und Regressionsaufgaben verwendet. Es ist besonders beliebt für Herausforderungen, bei denen hohe Genauigkeit und Geschwindigkeit erforderlich sind, wie in der Finanzmodellierung oder Risikoanalyse.

- Technologie: XGBoost bietet fortschrittliche Funktionen wie die Handhabung von fehlenden Daten, die Möglichkeit, benutzerdefinierte Optimierungsfunktionen zu verwenden, und Werkzeuge zur Überwachung der Modellleistung und -abstimmung.

Ähnlich wie LIME ist auch XGBoost auf der Plattform GitHub vertreten, wo Nutzer Zugriff auf den vollständigen Quellcode haben, Änderungen und Updates verfolgen und aktiv zur Weiterentwicklung des Projekts beitragen können.

Fuzzy Logic Modelle

Fuzzy Logic Modelle sind ein Ansatz in der Künstlichen Intelligenz, der darauf abzielt, die Art und Weise, wie Menschen ungenaue oder unscharfe Informationen verarbeiten, nachzubilden. Im Gegensatz zur traditionellen binären Logik, die auf klaren Ja-Nein-Entscheidungen basiert, ermöglicht die Fuzzy-Logik Zwischenstufen zwischen “wahr” und “falsch”.

Grundkonzept:

- Fuzzy Logic verwendet “Fuzzy Sets” oder unscharfe Mengen, bei denen ein Objekt zu einem gewissen Grad zu einer Menge gehören kann. Dies wird durch einen Wert zwischen 0 und 1 dargestellt, wobei 0 für “nicht zugehörig” und 1 für “vollständig zugehörig” steht.

- Diese Art der Modellierung eignet sich besonders gut für Probleme, bei denen die Daten ungenau oder unsicher sind oder eine menschenähnliche Entscheidungsfindung erforderlich ist.

Hauptanwendungen:

- Steuerungssysteme: Zum Beispiel in Haushaltsgeräten, Heizungs- und Kühlsystemen, bei denen Fuzzy Logic eine effiziente Regulierung basierend auf unscharfen Eingaben ermöglicht.

- Industrielle Steuerung: Einsatz in komplexen Steuerungs- und Regelungssystemen, wie in der chemischen Verarbeitung oder im Maschinenbau.

- Entscheidungsunterstützung: Unterstützung bei der Entscheidungsfindung in Szenarien, wo klare, binäre Entscheidungen nicht möglich sind.

Herausforderungen:

- Die Hauptkomplexität bei der Anwendung von Fuzzy Logic liegt in der Konstruktion der Fuzzy Sets und der Bestimmung der Zugehörigkeitsgrade. Dies erfordert oft Expertenwissen in dem jeweiligen Anwendungsbereich.

- Ein weiteres Problem kann die Integration von Fuzzy Logic-Systemen in bestehende Technologien sein, die auf traditioneller binärer Logik basieren.

Zukunftsperspektiven:

- Fuzzy Logic-Modelle werden weiterhin in Bereichen erforscht und entwickelt, in denen traditionelle logische Modelle an ihre Grenzen stoßen. Mit dem Fortschritt in Bereichen wie dem Internet der Dinge (IoT) könnte die Nachfrage nach flexibleren und adaptiveren Steuerungssystemen, die Fuzzy Logic nutzen, zunehmen.

Fuzzy Logic Modelle bieten einen einzigartigen Ansatz für die Handhabung von Unsicherheit und Unschärfe in Entscheidungsprozessen. Sie sind besonders wertvoll in Anwendungen, in denen die Daten mehrdeutig sind und eine flexible, menschenähnliche Verarbeitung erfordern.

Beispiel:

MATLAB Fuzzy Logic Toolbox

- Funktionsweise: Die Fuzzy Logic Toolbox in MATLAB bietet eine Umgebung für das Entwerfen von Fuzzy-Logic-Systemen. Sie ermöglicht es Nutzern, Fuzzy-Inferenzsysteme zu erstellen, zu bearbeiten und zu visualisieren und umfasst Funktionen für Fuzzy-Clustering, Fuzzy-Regelbasis-Systeme und vieles mehr.

- Anwendungsbereich: Diese Toolbox wird in verschiedenen Bereichen eingesetzt, darunter Steuerungs- und Regelungstechnik, Systemidentifikation und Signalverarbeitung. Sie eignet sich hervorragend für die Entwicklung von Systemen, die menschenähnliche Entscheidungsprozesse in unsicheren oder mehrdeutigen Umgebungen benötigen.

- Technologie: MATLAB bietet eine robuste und benutzerfreundliche Umgebung, die die Entwicklung und Simulation von Fuzzy-Logic-Systemen vereinfacht. Die Toolbox bietet auch umfangreiche Visualisierungs- und Analysewerkzeuge, um das Verständnis und die Feinabstimmung von Fuzzy-Systemen zu erleichtern.

Neurosymbolische Modelle

Neurosymbolische Modelle kombinieren die Fortschritte des Deep Learning (neuronale Netzwerke) mit den Prinzipien der symbolischen KI (regelbasierte Systeme), um die Vorteile beider Ansätze zu nutzen. Diese Modelle zielen darauf ab, komplexe Probleme zu lösen, die sowohl menschenähnliche Flexibilität und Lernfähigkeit als auch die Fähigkeit zur Verarbeitung abstrakter, symbolischer Informationen erfordern.

Grundkonzept:

- Neurosymbolische KI versucht, die Lernfähigkeit neuronaler Netzwerke mit der präzisen, logischen Verarbeitungsfähigkeit symbolischer Systeme zu kombinieren. Dieser Ansatz wird als vielversprechender Weg gesehen, um KI-Systeme zu entwickeln, die menschenähnliches Verstehen und Schlussfolgern ermöglichen.

- Ziel ist es, Systeme zu schaffen, die nicht nur aus Daten lernen, sondern auch komplexe Konzepte und Regeln verstehen und anwenden können.

Hauptanwendungen:

- Komplexe Entscheidungsfindung: In Bereichen, in denen Entscheidungen auf der Grundlage einer Kombination aus gelernten Daten und festgelegten Regeln getroffen werden müssen.

- Natürliche Sprachverarbeitung: Verstehen und Verarbeiten natürlicher Sprache unter Berücksichtigung von Kontext, Semantik und abstrakten Konzepten.

- Robotersteuerung: Integration von sensorischem Lernen und hochgradig strukturierten Aufgaben.

Herausforderungen:

- Eine der größten Herausforderungen ist die Integration der beiden Ansätze, da neuronale Netzwerke und symbolische Systeme grundlegend unterschiedliche Methoden und Repräsentationen verwenden.

- Ein weiteres Problem ist die Erklärbarkeit und Transparenz der Modelle, insbesondere in Bezug auf die Arbeitsweise der neuronalen Netzwerke.

Zukunftsperspektiven:

- Die Entwicklung neurosymbolischer Modelle steht noch am Anfang, aber sie hat das Potenzial, KI-Systeme zu schaffen, die komplexe, menschenähnliche Aufgaben bewältigen können. Zukünftige Forschungen konzentrieren sich auf bessere Integrationsmethoden und die Erweiterung der Anwendungsbereiche.

Neurosymbolische Modelle repräsentieren einen innovativen Ansatz in der KI-Forschung, der darauf abzielt, die kognitive Flexibilität menschlicher Intelligenz nachzubilden. Durch die Kombination von Deep Learning und symbolischer KI bieten sie spannende Möglichkeiten für die Entwicklung fortgeschrittener KI-Systeme.

Beispiel:

Neural-Symbolic Learning and Reasoning (NeSy)

- Funktionsweise: NeSy ist kein einzelnes Tool, sondern eher ein Forschungsbereich, der sich auf die Integration von neuronalem Lernen und symbolischem Schließen konzentriert. Es kombiniert Ansätze aus dem Deep Learning und der symbolischen KI, um Modelle zu entwickeln, die sowohl lernfähig als auch in der Lage sind, komplexe, abstrakte Informationen zu verarbeiten.

- Anwendungsbereich: Obwohl NeSy noch in der Forschungsphase ist, hat es das Potenzial, Anwendungen in verschiedenen Bereichen zu beeinflussen, einschließlich der natürlichen Sprachverarbeitung, der Robotik und der Entscheidungsfindung in komplexen Umgebungen.

- Technologie: Projekte im Bereich NeSy experimentieren mit verschiedenen Methoden, um neuronale Netzwerke mit symbolischen Systemen zu kombinieren, wie z.B. die Einbettung von symbolischen Wissensrepräsentationen in neuronale Netzwerke.

Obwohl NeSy noch ein aufstrebendes Feld ist, zeigt es das Potenzial, die KI-Forschung in Richtung Modelle zu führen, die menschenähnliches Verstehen und Schlussfolgern ermöglichen. Für Entwickler und Forscher, die sich für die neuesten Entwicklungen an der Spitze der KI interessieren, ist NeSy ein spannendes und vielversprechendes Forschungsgebiet.

Cognitive Computing Modelle

Cognitive Computing Modelle sind auf die Nachahmung der menschlichen Denkweise in der Künstlichen Intelligenz ausgerichtet. Sie kombinieren Elemente aus verschiedenen KI-Disziplinen, um Systeme zu schaffen, die komplexe Probleme in einer Art und Weise lösen können, die menschenähnliches Denken und Verstehen widerspiegelt.

Grundkonzept:

- Cognitive Computing nutzt maschinelles Lernen, Natural Language Processing (NLP), Bilderkennung und andere KI-Technologien, um menschenähnliche kognitive Fähigkeiten in Computern zu simulieren. Dazu gehören das Verstehen, Lernen, Argumentieren und die Interaktion in natürlicher Sprache.

- Diese Modelle zielen darauf ab, Entscheidungen zu treffen, die auf einer Analyse großer Mengen an strukturierten und unstrukturierten Daten basieren, ähnlich wie menschliche Experten es tun würden.

Hauptanwendungen:

- Gesundheitswesen: Unterstützung bei Diagnosen und Behandlungsplänen durch Analyse von Patientendaten und medizinischen Aufzeichnungen.

- Kundendienst: Entwicklung von Chatbots und virtuellen Assistenten, die natürlich mit Benutzern kommunizieren und komplexe Anfragen bearbeiten können.

- Finanzdienstleistungen: Risikoanalyse und Entscheidungsunterstützung durch Analyse von Marktdaten und Finanztrends.

Herausforderungen:

- Die Herausforderungen bei Cognitive Computing-Modellen liegen in der Integration und Verarbeitung von Informationen aus einer Vielzahl von Quellen und Formaten.

- Ein weiteres Problem ist die Erstellung von Systemen, die nicht nur Daten verarbeiten, sondern auch kontextbezogenes Verständnis und Lernfähigkeit zeigen.

Zukunftsperspektiven:

- Die Zukunft von Cognitive Computing liegt in der weiteren Entwicklung von Systemen, die noch menschenähnlicher agieren und interagieren können. Dazu gehört auch die Verbesserung der Fähigkeit, aus Erfahrungen zu lernen und sich an sich ändernde Umstände anzupassen.

Cognitive Computing Modelle bieten einen innovativen Ansatz zur Lösung komplexer Probleme und zur Verarbeitung von unstrukturierten Daten. Sie sind äußerst wertvoll in Anwendungen, in denen es auf menschenähnliche Intelligenz und eine tiefere semantische Analyse ankommt.

Beispiel:

IBM Watson

- Funktionsweise: IBM Watson ist eine KI-Plattform, die fortschrittliche Algorithmen für maschinelles Lernen, Natural Language Processing und Datenanalyse integriert, um komplexe Probleme in einer Vielzahl von Anwendungsbereichen zu lösen.

- Anwendungsbereich: Watson wird in verschiedenen Branchen eingesetzt, einschließlich Gesundheitswesen, Finanzen, Recht und Kundenservice. Es bietet Lösungen wie virtuelle Assistenten, personalisierte Empfehlungen, Datenanalyse und tiefgehende Einblicke.

- Technologie: Watson verarbeitet große Mengen an strukturierten und unstrukturierten Daten, um Muster zu erkennen, Schlussfolgerungen zu ziehen und menschenähnliche Antworten auf komplexe Fragen zu geben. Die Plattform ist bekannt für ihre Fähigkeit, in natürlicher Sprache zu kommunizieren und zu lernen, was sie besonders für Anwendungen geeignet macht, bei denen Interaktionen mit Menschen im Vordergrund stehen.

Quantencomputing-basierte Modelle

Quantencomputing-basierte Modelle repräsentieren eine aufstrebende und revolutionäre Technologie in der Welt der Künstlichen Intelligenz. Diese Modelle nutzen die Prinzipien der Quantenmechanik, um komplexe Berechnungen durchzuführen, die für klassische Computer unpraktikabel wären.

Grundkonzept:

- Während traditionelle Computer Bits verwenden, die entweder 0 oder 1 sind, nutzen Quantencomputer Quantenbits (Qubits), die gleichzeitig mehrere Zustände darstellen können. Diese Fähigkeit, mehrere Zustände gleichzeitig zu halten und zu verarbeiten, ermöglicht es Quantencomputern, Probleme mit exponentieller Geschwindigkeit zu lösen.

- Quantencomputing-basierte Modelle könnten theoretisch komplexe Optimierungs- und Simulationsprobleme lösen, die für herkömmliche Computer zu komplex sind.

Hauptanwendungen:

- Materialwissenschaft: Beschleunigung der Entdeckung neuer Materialien durch Simulation ihrer molekularen Strukturen.

- Pharmazie: Entwurf neuer Medikamente durch die Analyse großer molekularer Datenbanken.

- Kryptographie: Entwicklung neuer Kryptographie-Methoden, da Quantencomputer in der Lage sein könnten, herkömmliche Verschlüsselungstechniken zu brechen.

Herausforderungen:

- Eine der größten Herausforderungen im Quantencomputing ist die technische Schwierigkeit, stabile und skalierbare Quantensysteme zu entwickeln. Quantencomputer sind extrem empfindlich gegenüber Umgebungsstörungen.

- Ein weiteres Problem ist die Entwicklung von Algorithmen, die speziell für die Quantenverarbeitung geeignet sind.

Zukunftsperspektiven:

- Obwohl Quantencomputing noch in einem frühen Stadium ist, wird erwartet, dass es in den kommenden Jahren enorme Fortschritte macht. Es hat das Potenzial, die Art und Weise, wie wir über Datenverarbeitung und Problemverarbeitung denken, grundlegend zu verändern.

Quantencomputing-basierte Modelle stehen an der Grenze zwischen KI und Quantenphysik und bieten eine aufregende Perspektive für die Zukunft der Technologie. Mit der Fähigkeit, Aufgaben zu lösen, die heutige Supercomputer nicht bewältigen können, könnten sie die Grenzen dessen, was in der Welt der KI und darüber hinaus möglich ist, erheblich erweitern.

Beispiel:

IBM Qiskit

- Funktionsweise: Qiskit ist ein Open-Source-Quantencomputing-Framework, das von IBM entwickelt wurde. Es ermöglicht Nutzern, Quantencomputer zu programmieren, zu simulieren und zu betreiben. Qiskit ist darauf ausgerichtet, die Quantenprogrammierung zugänglicher und verständlicher zu machen.

- Anwendungsbereich: Obwohl es derzeit hauptsächlich für Forschungszwecke verwendet wird, hat Qiskit das Potenzial, in verschiedenen Bereichen eingesetzt zu werden, darunter auch in der KI, zur Lösung von Optimierungsproblemen oder für Fortschritte in der Materialwissenschaft.

- Technologie: Qiskit bietet eine Vielzahl von Tools und Bibliotheken, die es Forschern und Entwicklern ermöglichen, Experimente mit Quantenalgorithmen durchzuführen und theoretische Modelle in praktische Anwendungen umzusetzen.

Meta Learning Modelle

Meta-Learning, oft auch als “Lernen zu Lernen” bezeichnet, ist ein fortschrittlicher Ansatz im maschinellen Lernen, der darauf abzielt, Algorithmen zu entwickeln, die den Lernprozess selbst optimieren. Meta-Learning-Modelle sind darauf ausgelegt, aus einer Vielzahl von Aufgaben zu lernen und dieses Wissen zur schnelleren und effektiveren Bewältigung neuer, ähnlicher Aufgaben zu verwenden.

Grundkonzept:

- Im Kern von Meta-Learning steht die Idee, dass ein KI-Modell nicht nur für eine spezifische Aufgabe trainiert wird, sondern lernt, wie es Lernaufgaben im Allgemeinen effektiver bewältigen kann. Dies umfasst die Optimierung von Lernalgorithmen, die Anpassung von Modellen an neue Aufgaben mit minimalen Daten oder das schnelle Umschalten zwischen verschiedenen Arten von Aufgaben.

- Meta-Learning-Modelle sind besonders nützlich in Szenarien, wo schnelle Anpassungsfähigkeit und das Lernen aus wenigen Beispielen (Few-Shot Learning) erforderlich sind.

Hauptanwendungen:

- Few-Shot Learning: Fähigkeit, aus einer sehr kleinen Anzahl von Beispielen schnell zu lernen, nützlich in Bereichen wie der medizinischen Bildgebung.

- Automatisierte Modellselektion: Auswahl und Optimierung von ML-Modellen für spezifische Aufgaben basierend auf früheren Erfahrungen.

- Cross-Domain-Adaptation: Anpassung von Modellen an neue Domänen oder Aufgaben, für die sie ursprünglich nicht trainiert wurden.

Herausforderungen:

- Eine Herausforderung bei Meta-Learning ist die Komplexität der Modelle und die Notwendigkeit, eine Balance zwischen Spezialisierung auf bestimmte Aufgaben und der Flexibilität für das Lernen neuer Aufgaben zu finden.

- Ein weiteres Problem ist die Entwicklung effizienter Algorithmen, die in der Lage sind, aus einer begrenzten Menge an Erfahrungen zu lernen.

Zukunftsperspektiven:

- Zukünftige Entwicklungen im Bereich Meta-Learning könnten darauf abzielen, noch flexiblere und anpassungsfähigere KI-Modelle zu schaffen. Dies würde die Anwendungsbereiche von KI erweitern und könnte zu bedeutenden Fortschritten in Bereichen wie personalisierter Medizin, autonomem Lernen und adaptiven KI-Systemen führen.

Meta-Learning Modelle repräsentieren einen innovativen und vielversprechenden Bereich der KI-Forschung, der darauf abzielt, die Art und Weise, wie Maschinen lernen, zu optimieren und zu revolutionieren. Durch das Training von Modellen, die effektiver und schneller lernen können, eröffnen sich neue Möglichkeiten für die Anwendung von KI in verschiedenen Bereichen.

Beispiel:

MAML (Model-Agnostic Meta-Learning)

- Funktionsweise: MAML ist ein Ansatz im Meta-Learning, der darauf abzielt, Modelle zu entwickeln, die sich schnell an neue Aufgaben anpassen können. Es ist „modellagnostisch“, was bedeutet, dass es mit einer Vielzahl verschiedener Arten von Lernalgorithmen und Architekturen kompatibel ist.

- Anwendungsbereich: MAML wird hauptsächlich in Forschungsumgebungen eingesetzt, insbesondere für Aufgaben, die schnelles Lernen aus wenigen Daten erfordern, wie Few-Shot Learning oder schnelle Adaption an neue Aufgaben.

- Technologie: Der Kern von MAML ist ein Trainingsverfahren, das ein Modell darauf vorbereitet, mit minimalen Anpassungen schnell auf eine neue Aufgabe umgestellt zu werden. Dies wird erreicht, indem das Modell so trainiert wird, dass es einen Parameterbereich findet, der für eine Vielzahl von Aufgaben gut geeignet ist.

Diskussion über die Komplexität der Zuordnung

Die Zuordnung spezifischer KI-Modelle zu festgelegten Hauptkategorien des maschinellen Lernens ist oft eine komplexe und nicht immer direkt umsetzbare Aufgabe. Dies liegt vor allem an der Interdisziplinarität und den Überschneidungen, die zwischen verschiedenen Modellen und Ansätzen in der KI bestehen.

In der Welt der Künstlichen Intelligenz gibt es eine Vielzahl von Modellen und Methoden, die sich in ihrer Funktionsweise und ihrem Anwendungsbereich unterscheiden. Einige Modelle können Merkmale aus mehreren Hauptkategorien wie Supervised Learning, Unsupervised Learning, Reinforcement Learning und Deep Learning kombinieren. Zum Beispiel nutzen Deep Reinforcement Learning-Modelle sowohl Techniken des tiefen Lernens als auch des Reinforcement Learning, um komplexe Probleme zu lösen, die eine Kombination aus Wahrnehmung (typisch für Deep Learning) und Entscheidungsfindung (typisch für Reinforcement Learning) erfordern.

Darüber hinaus gibt es Modelle, die eigenständige Ansätze darstellen und sich nicht klar in die herkömmlichen Kategorien einordnen lassen. Beispiele hierfür sind neurosymbolische Modelle, die versuchen, die symbolische KI (basierend auf expliziten Regeln und Logik) mit lernbasierten Ansätzen zu kombinieren, oder Quantencomputing-basierte Modelle, die eine völlig andere Rechenarchitektur nutzen.

Diese Komplexität und Vielfältigkeit in der KI sind ein Beweis für die Dynamik und ständige Entwicklung im Feld. KI ist ein sich schnell entwickelndes Gebiet, in dem Forscher ständig neue Methoden erforschen und bestehende Techniken verbessern. Diese fortlaufende Innovation führt zu immer mehr hybriden und interdisziplinären Ansätzen, die die Grenzen dessen, was mit KI möglich ist, ständig erweitern.

Die Herausforderung, spezifische KI-Modelle eindeutigen Kategorien zuzuordnen, spiegelt somit die fortgeschrittene und facettenreiche Natur der KI als wissenschaftliches und technologisches Feld wider. Es zeigt, dass KI nicht nur eine Sammlung von isolierten Techniken ist, sondern ein sich entwickelndes Ökosystem von Methoden und Ideen, die sich gegenseitig beeinflussen und vorantreiben.

4 Typen von KI

Im Verlauf dieses Blogbeitrags haben wir uns eingehend mit den aktuellen Entwicklungen und spezifischen Modellen der Künstlichen Intelligenz beschäftigt. Bevor wir diesen Beitrag abschließen, möchten wir einen Blick in die Zukunft werfen. Im folgenden Abschnitt beschäftigen wir uns mit den vier Typen von KI – von reaktiven Maschinen bis hin zu Systemen mit Selbstbewusstsein. Diese Betrachtung bietet nicht nur spannende Einblicke in das, was möglicherweise kommen wird, sondern rundet auch unser Verständnis der KI in ihrem gesamten Spektrum ab. Lassen Sie uns gemeinsam erkunden, welche theoretischen und zukünftigen Entwicklungen in der Welt der Künstlichen Intelligenz auf uns warten könnten:

Typ 1: Künstliche Intelligenz mit reaktiven Maschinen (Reaktive Machine)

Diese KI-Systeme haben die grundlegendste Form der KI. Sie reagieren auf bestimmte Eingaben oder Situationen, haben aber keine Fähigkeit, Erfahrungen zu speichern oder von der Vergangenheit zu lernen. Ein klassisches Beispiel ist das Schachprogramm Deep Blue von IBM, das in der Lage war, Schach zu spielen, aber keine Fähigkeit zur Speicherung von Erfahrungen oder zum Lernen aus vergangenen Spielen hatte.

Typ 2: Begrenzte Speicherkapazität (Limited Memory)

KI-Systeme dieses Typs können vergangene Daten und Erfahrungen über einen begrenzten Zeitraum speichern und nutzen. Dies ist ein Schritt über den rein reaktiven Maschinen hinaus, da diese Systeme Informationen aus der jüngeren Vergangenheit verwenden können, um Entscheidungen zu treffen. Ein Beispiel hierfür sind selbstfahrende Autos, die ständig Daten über ihre Umgebung sammeln und für unmittelbare Entscheidungen wie Spurwechsel oder Geschwindigkeitsanpassung nutzen.

Typ 3: Theorie des Geistes (Theory of Mind)

Diese Kategorie bezieht sich auf eine fortgeschrittenere Ebene der KI, die noch größtenteils theoretisch und nicht realisiert ist. KI-Systeme mit “Theorie des Geistes” würden über das Verständnis verfügen, dass andere Wesen (Menschen, andere KI-Systeme) ihre eigenen Überzeugungen, Absichten und Wünsche haben. Dies erfordert ein tiefes Verständnis von Emotionen, sozialen Signalen und menschlichem Verhalten.

Typ 4: Selbstwahrnehmung (Self-Awareness)

Dies ist die fortschrittlichste und derzeit noch theoretische Form der KI. Selbstbewusste KI-Systeme würden ein eigenes Bewusstsein, Emotionen und ein Selbstverständnis haben. Sie wären sich ihrer selbst, ihrer Rolle in der Umgebung und der Existenz und emotionalen Zustände anderer bewusst. Diese Art von KI existiert derzeit nur in der Science-Fiction und der theoretischen Forschung.

#KünstlicheIntelligenz#KI-Modelle#Algortihmen#Technologie