Im Zusammenhang mit Webseiten und Suchmaschinenmanagement ist immer wieder von sogenannten „Webcrawlern“ die Rede. Doch worum handelt es sich hierbei eigentlich genau? Wie arbeitet ein Webcrawler? Und weshalb ist es für Seitenbetreiber so wichtig, den Stellenwert der Webcrawler nicht zu unterschätzen?

[toc]

Definition

Verallgemeinernd ausgedrückt handelt es sich bei einem Webcrawler um ein Computerprogramm, dessen Aufgabe es ist, das www nach Informationen zu durchsuchen. Besonders oft kommt dieses Programm im Zusammenhang mit der Indexierung von Seiten zum Einsatz.

Die Daten, die auf diese Weise gesammelt werden, werden im Nachhinein sortiert und ausgewertet. Auf diese Weise können Rückschlüsse darauf gezogen werden, inwieweit das Potenzial der eigenen Internetpräsenz schlussendlich genutzt wird.

Unter anderem werden Webcrawler auch als „Robots“ oder „Searchbots“ bezeichnet.

Wozu dienen Webcrawler?

Webcrawler werden in den meisten Fällen dazu genutzt, um Webseiten zu indexieren. Damit die Seiten im Rahmen der Suchmaschinenergebnisse berücksichtigt werden können, ist es die Aufgabe des Crawlers, sie zu besuchen, sie „abzucrawlen“ und wichtige Infos über deren Inhalt zu speichern.

Hinter dem entsprechenden Verfahren steht ein standardisierter Automatismus, der sich in regelmäßigen Abständen wiederholt.

Um ein bestmögliches Ergebnis zu gewährleisten, besuchen die Crawler Webseiten immer und immer wieder. Somit stellen sie sicher, dass auch etwaige Veränderungen, wie zum Beispiel neue Blogbeiträge, möglichst rasch berücksichtigt und entsprechend im Index abgespeichert werden können. Nach neuen „Erkenntnissen“ wird der besagte Index dann dementsprechend aktualisiert.

Vereinfacht ausgedrückt erstellt der Webcrawler eine Art „Katalog“, der die Suchmaschinen darüber informiert, wo sie welche Informationen finden und welche Seiten dem User entsprechend angeboten werden.

In diesem Zusammenhang ist es jedoch auch wichtig, zu berücksichtigen, dass Webcrawler nicht dazu in der Lage sind, wirklich alle Details, die sich auf einer Webseite befinden, zu erkennen und zu speichern. So fallen beispielsweise Daten, die sich in Datenbanken oder auf Suchmasken befinden, durch das Raster und werden daher nicht berücksichtigt. Wozu ein Webcrawler letztendlich genau dient, ist zu einem großen Teil von der Art des Crawlers abhängig. So sind manche Techniken darauf spezialisiert, Mailadresse zu sammeln. Andere befassen sich mit Konditionen zu bestimmten Produkten oder mit der klassischen Informationsvermittlung.

Wie funktionieren Webcrawler?

So detailliert moderne Webcrawler auch arbeiten mögen: Das Prinzip, das sich hinter ihnen verbirgt ist so gut wie immer gleich. Um die dazugehörige Technik besser verstehen zu können, ist es wichtig, sich in Erinnerung zu rufen, dass sich das www quasi sekündlich verändert. Die Aufgabe der Webcrawler ist es, genau das festzuhalten. Sie durchforsten zunächst die ihnen bekannten Seiten und nehmen dann an den entsprechenden Stellen immer wieder Abzweigungen. Auf diese Weise wird die Liste ihrer bekannten Seiten länger und länger. Die erweiterte Liste wird dann wiederrum als Ausgangsbasis für die „nächste Runde“ genutzt.

Auf Basis einer speziellen Technik entwickeln die Crawler ein bestimmtes System, um hier noch ein wenig logischer vorgehen zu können. Hier spielen dann Fragen, wie zum Beispiel „Welche Seite soll als erstes durchsucht werden?“, „Wie kann die Serverlast, die mit Hinblick auf die Arbeit eines Webcrawlers anfällt, aufgefangen werden?“ und „Wie oft soll eine Webpräsenz durchgecrawlt werden?“ spielen in diesem Zusammenhang eine wichtige Rolle.

Hinzu kommt, dass die meisten Webcrawler „nur“ einen Teil des Internets durchsuchen. Ein Detail, das dafür sorgt, dass viele Crawler besonders oft vorbeischauen, ist, wenn besonders viele andere Seiten auf die „Seite X“ verlinken. Immerhin handelt es sich hierbei um ein Anzeichen dafür, dass die betreffende Webpräsenz offenbar in vielerlei Hinsicht interessant ist. Auf diese Weise wird bereits eine Art „Vorauswahl“ getroffen. Diese bewirkt, dass die betreffende Seite in der Regel öfter vom Webcrawler besucht wird.

Unsere passenden Seminare

Sie möchten mehr zu Suchmaschinenoptimierung lernen? Dann besuchen Sie unser Seminar Suchmaschinenoptimierung! Darin lernen Sie relevante Inhalte zur Suchmaschinenoptimierung sowie Prozesse, Tools zur Keyword-Recherche und Methoden zur Content Erstellung kennen.

Falls Sie jedoch erfahren möchten, wie Sie am besten Ihren Content gestalten, kann unser Content Marketing Seminar eine ausgezeichnete Wahl sein.

Umfassendere Informationen zum Thema Online Marketing bietet hingegen das Online Marketing kompakt Seminar. Infomieren Sie sich hier über aktuelle Termine und genaue Inhalte:

Die Funktionsweise von Webcrawlern lässt sich wie folgt zusammenfassen:

- regelmäßige Besuche auf Webseiten

- Durchforsten der Webseiten nach Begriffen

- Einschätzung der Relevanz von Webseiten, um Usern ein bestmögliches Nutzererlebnis zu bieten.

Zu guter Letzt gilt, dass sich die Webcrawler unterschiedlicher Suchmaschinen auch jeweils unterschiedlich verhalten. So arbeitet der Googlebot beispielsweise anders als der Bingbot usw. . Die Zielsetzung, die sich hinter ihrem Einsatz verbirgt, ist jedoch immer gleich. Es geht darum, dem Suchmaschinennutzer dabei zu helfen, im Internet genau die Inhalte zu finden, nach denen dieser Ausschau hält.

Online-Zertifikatslehrgang Online Marketing Manager (DIM)

Das Thema Webcrawler, Suchmaschinenoptimierung, SEA, Social Media Marketing, etc. interessiert sie? In unserem Zertifikatslehrgang Online Marketing Manager (DIM) lernen Sie alle Elemente des Online Marketing kennen. Informieren Sie sich jetzt! Ihr Einstieg ist jederzeit möglich.

Welche Anweisungen kann man Bots geben?

Die Arbeit eines Webcrawlers lässt sich weitaus besser individualisieren als es im ersten Moment möglicherweise den Anschein haben mag. Es geht hier bei Weitem nicht „nur“ darum, eine Seite bestmöglich „von oben bis unten“ zu lesen. Die folgenden Abschnitte zeigen, dass es auch innerhalb des Aufgabenbereichs eines Webcrawlers möglich ist, individuelle Akzente zu setzen.

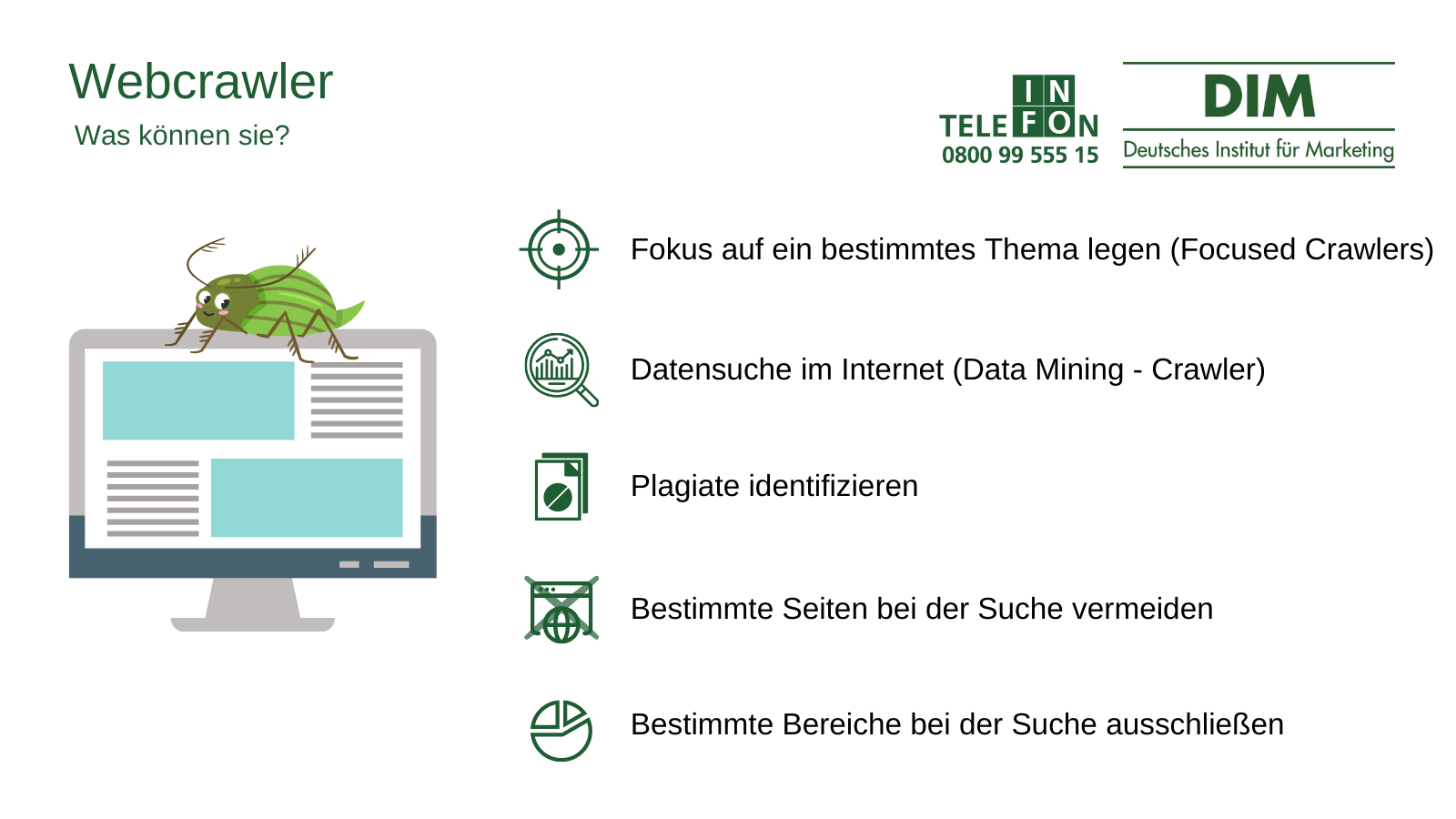

- Die Aufgabe eines sogenannten „Focused Crawlers“ ist es beispielsweise, sich ausschließlich auf ein spezielles Thema zu fokussieren.

- „Data Mining“ Crawler“ suchen im Internet nach Daten, wie zum Beispiel bestimmten Profilen von Nutzern oder Mail Adressen.

- Ergänzend hierzu gibt es auch Webcrawler, die darauf ausgerichtet sind, Plagiate oder Duplicate Content zu finden.

Ergänzend hierzu gibt es noch weitere Befehlsarten, die die Arbeit eines Webcrawlers noch individueller werden lassen können. So ist es unter anderem möglich, einem Bot zu verbieten, eine Seite zu untersuchen. Zudem können – mit den entsprechenden Befehlen – auch nur bestimmte Bereiche ausgeschlossen werden. Häufig kommt letztgenannte Technik zum Einsatz, wenn sichergestellt werden soll, dass keine Anzeigen, die auf der Seite geschaltet wurden, untersucht werden.

In der Regel werden Meta-Tags genutzt, um Crawler zu steuern. Diese werden in den jeweiligen Head-Bereich der Seiten eingesetzt.

Um hier bestmöglich vorzugehen, ist es sinnvoll, sich eingehend mit den verschiedenen Möglichkeiten auseinanderzusetzen. Wer hierfür keine Zeit hat bzw. sich weiter seinem „normalen Tagesgeschäft“ widmen möchte, ohne sich um Webcrawler, Bots und Co. zu kümmern, kann sich mit seinen Fragen auch an eine professionelle Marketingagentur wenden. Immerhin ist es auf Basis der entsprechenden Techniken unter anderem möglich, die Suchmaschinenoptimierung weiter voranzutreiben. Im Idealfall kann eine optimale Durchsuchung der Seite gewährleistet werden, damit auch wirklich alle Details, die eine Webpräsenz – im öffentlichen Bereich – zu bieten hat, in den Suchmaschinen berücksichtigt werden können.

#Webcrawler #Web #Crawler #Bots #Robots #Searchbots #FocusedCrawler #DataMiningCrawler

Tel.: +49 (0)221 – 99 555 10 12

Fax: +49 (0)221 – 99 555 10 77

E-Mail senden

[/vc_cta]